Einleitung

Mit „Linking Open Data“ [W3C] hat das Semantic Web in den letzten Jahren eine zuvor unbekannte Popularität entwickelt. Jahrelang war diese W3C Activity mit der Vereinheitlichung der Beschreibung formaler Logik ausgelastet, also eher mit einem Thema der künstlichen Intelligenz, die bereits den Zenit ihrer Popularität überschritten hatte. 2007 entstand plötzlich eine Gegenbewegung, die an die ersten Jahre des Internet anknüpft. In der zweiten Hälfte der 1990er Jahre war mit rasender Geschwindigkeit ein immer größeres Netz von On-Line Information herangewachsen, das einen neuen de-facto Standard etablierte: HTML. 1998 war auch das Resource Description Framework (RDF) bereits W3C Standard, und Tim Berners-Lee entwarf das Semantic Web als (maschinenlesbare) globale Datenbank. Doch die Semantic Web Activity befasste sich mit den Feinheiten formaler Logik und versäumte die Gelegenheit, dem bekannten Internet diese globale Datenbank folgen zu lassen. LOD holt genau dies nach. Hier geht es um die Veröffentlichung von Alltagsdaten in maschinenlesbarer Form und um die Vernetzung dieser Daten untereinander. Auch wenn dies von vielen noch als akademische Spielwiese angesehen wird, entstehen dabei nach und nach belastbare Verfahren und Datennetze, die auch von Medienunternehmen und Regierungsorganisationen vorangetrieben werden. Dies sollte auch eine weitergehende kommerzielle Verwendung nahe legen. Ähnlich wie bei der Entwicklung des „klassischen“ Internet in den 1990ern werden industrielle Unternehmen auf den Plan treten und das von LOD geschaffene Netz in nicht vorhersehbarer Weise vorantreiben.

Offene Daten

Der Begriff „offen“ hat hier zwei Bedeutungen. Zum einen geht es um den freien Zugang zu den Daten, zum andern um die dabei verwendeten offenen Standards. Gefordert wird zunächst eine „offene Zugänglichkeit aller Formen von Wissen“ [1]. Die deutsche Sektion der Open Knowledge Foundation hat dazu z.B. die Plattform „Offene Daten“ [2] geschaffen, wo bisher rund 500 Datenbanken von Behörden zum Download vorliegen. Die internationale OKFN verfolgt diese Ziele bereits seit 2004. 2009 hat Barack Obama mit seinem Memorandum „Transparency and Open Government“ [3] einen ähnlichen Begriff in den oberen Etagen vieler Regierungen populär gemacht. Im Juli 2012 legte das Bundesinnenministerium eine entsprechende Studie [4] vor. Gleich im Geleitwort macht Hans-Peter Friedrich deutlich: „Offene Daten sind ein ökonomischer Schatz“. Man verspricht sich „neue Anwendungen, Dienstleistungen mit Mehrwert und neue Geschäftsmodelle“. Eine aktuelle Gartner Studie bringt es auf den Punkt: „Big Data macht Organisationen smarter, Open Data macht sie reicher“ [5]. Es mischen sich also hier ethische und wirtschaftliche Motive, was zusammen eine eigene Dynamik generiert.

Offene Standards

Während die juristische oder politische Klärung eines „offenen“ Zugangsrechts nicht zum Metier des Informatikers gehört, bilden offene Standards eine Grundlage unseres Berufs. Mit Bezug auf diese Bedeutung von Offenheit hat Tim Berners-Lee, Direktor des World Wide Web Consortiums (W3C), ein 5-Sterne Ranking ins Leben gerufen [W3C] (eigene Übersetzung):

| * | Im Web verfügbar, gleich welchen Formats, aber mit einer offenen Lizenz |

| ** | Verfügbar als strukturierte Daten (z.B.. Excel anstatt einer Tabelle als Graphik) |

| *** | Wie **, aber in einem nicht-proprietären Format (z.B. CSV anstatt Excel) |

| **** | Alles Vorige, aber offene Standards des W3C (RDF und SPARQL) um die Entitäten zu identifizieren, damit die Nutzer darauf verweisen können |

| ***** | Alles Vorige, zusätzlich: Vernetzung der Daten mit anderen Daten, um den Kontext zu zeigen. |

Die bereits zitierte Studie des BMI kommt zu dem Schluss, dass „90 % der untersuchten Ressourcen (…) aller föderalen Ebenen im Format PDF vorhanden“ sind, also ein Stern. Sie betont ebenso, dass „die Verarbeitbarkeit der Ressourcen relativ einfach über Bereitstellung der Daten in anderen Formaten (z XLS, CSV) erhöht werden“ könnte (S. 384). Es findet sich auch eine Handlungsempfehlung, nach der „Mehrwerttechnologien semantischer Daten (Linked Data) angebunden“ (S. 434) werden sollen.

Mit Linked Data ist ein technisches Muster angesprochen, das die Begrifflichkeit von „offen“ wesentlich erweitert. Die Vision dahinter ist nichts Geringeres als die „Weiterentwicklung des Web zur globalen Datenbank“ [6], was Berners-Lee bereits 1998 in seiner Semantic Web Roadmap [W3C] vorschwebte.

Voraussetzung dafür ist, dass jede Entität dieser Datenbank durch eine Webadresse repräsentiert wird, die Aussagen zu dieser Entität erschließt. Dies gilt gleichermaßen für die Daten und ihr zugrunde liegendes Schema. Die auch in XML bekannten Namespaces werden so zu Webadressen von einzelnen Strukturdefinitionen erweitert.

Durch die seit HTTP 1.1 bekannte „Content Negotiation“ kann jede dieser URIs wahlweise menschenlesbare (HTML) oder maschinenlesbare (RDF) Formate anbieten. Wesentlich sind hier vor allem die maschinenlesbaren, da nur sie eine strukturierte Recherche und automatisierte Schlussfolgerungen erlauben.

RDF beschreibt gerichtete Graphen und kennt ausschließlich Aussagen in Form von Tripeln aus Subjekt, Prädikat und Objekt. Damit ist jeder RDF Parser unabhängig vom jeweils vorliegenden Schema universell einsetzbar. Die Schemadefinitionen kann er bei Bedarf gleich mitparsen.

XML degradiert hier zu einer Syntax neben anderen. Die derzeit beliebteste RDF-Syntax ist die Terse RDF Triple Language „Turtle“ [W3C]. In Turtle liest sich eine Beschreibung von DBPedia, der maschinenlesbaren Fassung des bekannten Wikipedia, wie folgt:

Listing 1: RDF-Metadaten zu DBPedia in Turtle-Syntax

@prefix void: <http://rdfs.org/ns/void#> .

@prefix dcterms: <http://purl.org/dc/terms/> .

:DBpedia a void:Dataset ;

dcterms:title "DBPedia" ;

dcterms:description "RDF data extracted from Wikipedia" ;

dcterms:contributor :FU_Berlin ;

dcterms:contributor :University_Leipzig ;

dcterms:contributor :OpenLink_Software ;

dcterms:contributor :DBpedia_community ;

dcterms:source <http://dbpedia.org/resource/Wikipedia> ;

dcterms:modified "2008-11-17" .Wird ein Statement (Triple) mit Semikolon beendet, so bezieht sich das folgende auf dasselbe Subjekt. Erst der Punkt schließt eine solche Sequenz von Aussagen. Die XML Serialisierung ist weit umständlicher, und es existieren unterschiedliche Muster, weshalb sie in der Linked Data Community zunehmend ins Hintertreffen gerät.

Das Beispiel ist der Spezifikation des Vocabulary of Interlinked Datasets (VoID) entnommen, ein aktueller Metadatenstandard des W3C. RDF ist jedoch nicht auf die Beschreibung von Metadaten beschränkt. Grundsätzlich lässt sich z.B. jede relationale Tabelle verlustfrei abbilden, indem der Schlüsselwert einer Zeile als Subjekt verwendet wird, die Spaltentitel als Attribute und die Werte in den Spalten als Objekte. Die Tabelle selbst wird dabei zur Klasse, das Subjekt zu ihrer Instanz. Eine Tabelle „Produkte“ hat zum Beispiel folgende Struktur:

| ID | Name | Produktlinie | Verfügbarkeit |

|---|---|---|---|

| 4711 | Marillentorte | schlanke Linie | 666 |

Daraus wird verlustfrei:

Listing 2: Abbildung einer relationalen Tabellenzeile in RDF

4711 a :Produkt ;

:name „Marillentorte“ ;

:produktLinie „schlanke Linie“ ;

:verfuegbarkeit 666 .In diesem Beispiel sind einige „ungeschriebene“ Namens-Konventionen berücksichtigt, aber dies ist für das Funktionieren nicht zwingend erforderlich. Tabellen- und Spaltennamen können unbesehen als Namen von Klassen und Properties verwendet werden. Die Tripel werden idealerweise in einer speziellen Datenbank (Triple Store) gehalten und können dort über die SPARQL Query Language [W3C] angesprochen werden, ähnlich wie relationale Daten mit SQL.

Aus der relationalen Perspektive erscheint ein Triple Store wie eine Datenbank mit einer einzigen, dreispaltigen Tabelle (Subjekt, Prädikat, Objekt). Es ist offensichtlich, dass hier ganz andere physikalische Optimierungen erforderlich sind und eben auch eine andere Abfragesprache: die SPARQL Protocol And RDF Query Language. Dies ist eine Pattern-orientierte Sprache, die Konjunktionen, Disjunktionen und weitere optionale Muster umfasst. Die Rückgabe ist frei formatierbar, wobei RDF eher selten verwendet wird. Gebräuchlicher sind z.B. anwendungsorientierte Strukturen in JSON, die direkt in Mash-Ups zur Visualisierung eingebunden werden. Ursprünglich als reine Abfragesprache für einzelne Endpunkte konzipiert, umfasst der aktuelle Working Draft 1.1 auch `SPARQL UPDATE und eine „federated query“, die mehrere Endpunkte in einem einzigen Statement ansprechen kann.

Vor einem objekt-orientiertem und relationalen Hintergrund scheint dies bereits gewöhnungsbedürftig, aber der größte Unterschied liegt letztlich in der „Open World Assumption“ [W3C], die sich zwingend aus der Idee einer globalen Web-Datenbank ergibt.

Vernetzte Offene Daten

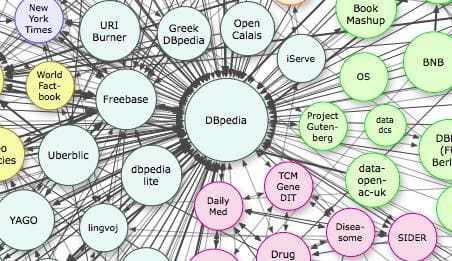

Seit 2007 ist nach den oben zitierten Prinzipen des 5-Sterne-Rankings die Linking Open Data [W3C] Bewegung entstanden, die aus anfänglich 12 RDF Datenbanken bestand und bis heute auf 327 angewachsen ist. Insgesamt liegen mehrere Milliarden von vernetzten Tripeln vor.

Hier sind nicht nur Datenbanken oder –sammlungen als Ganzes miteinander vernetzt, sondern in erster Linie ihre Datensätze.

Dabei lassen sich zwei Arten von Vernetzung unterscheiden:

- Verweis auf Referenzterminologie

- Verweis auf ergänzende Aussagen Anderer

Der oben abgebildete Ausschnitt zeigt DBPedia (das als Linked Data publizierte Wikipedia) als Referenzterminologie für eine Vielzahl von Datenbanken. Wenn z.B. das Projekt Gutenberg eine Aussage über den Dichter Novalis macht, dann sagt es auch, dass dies derselbe ist wie der Dichter Novalis in Wikipedia. Dort erfährt man u.a., dass Novalis der Künstlername von Georg Philipp Friedrich Freiherr von Hardenberg war und dass die Buchstabenfolge „Novalis“ auch der Name einer Zeitschrift ist. Da der Verweis auf DBPedia aber die Form einer Webadresse hat, zeigt er eindeutig auf den Dichter. Und da beide Datenbanken offen im Web verfügbar sind, spielt es keine Rolle, dass sie physikalisch in verschiedenen Datenbankinstanzen auf verschiedenen Servern liegen.

Natürlich kann jeder Akteur im Web auf Wikipedia verweisen, ohne deren Mentoren darüber zu informieren. Üblicherweise wissen diese gar nichts davon und verweisen auch nicht zurück. Da wir es aber im Linked Data Web mit einer einzigen globalen Datenbank zu tun haben, können wir mit einem SPARQL Statement abfragen, wer in aller Welt auf einen bestimmte DBpedia Entität verweist. Diese global verteilte RDF–Recherche ist derzeit noch bruchstückhaft verfügbar, wird aber als SPARQL 1.1 Federated Query [W3C] standardisiert und ist auch bereits in einigen RDF Datenbanken implementiert.

Nun gilt Wikipedia für viele Organisationen nicht als zuverlässige Referenzterminologie, da sie deren Inhalte nicht exklusiv kontrollieren können. Also sind zahlreiche spezialisierte Terminologien in Gebrauch und auch diese werden untereinander vernetzt. Das Simple Knowledge Organisation System (SKOS) [W3C] ist ein Standard zur Beschreibung solcher Thesauri, Klassifikationen, Schlagwortlisten oder Taxonomien. Er enthält auch differenzierte Sprachelemente zur Abbildung von Ähnlichkeiten zwischen Konzepten unterschiedlicher Herkunft, mit denen eine gewünschte Distanz zur „Folksonomy“ des Web 2.0 gewahrt werden kann.

Dagegen spielt das beliebte, aber auch berüchtigte owl:sameAs eine nicht unbedenkliche Rolle. OWL, die Web Ontology Language [W3C] ist eine Weiterentwicklung auf Basis von RDF, in der eine ganze Reihe von logischen Axiomen definiert ist. Wenn nun ein sogenannter Reasoner (dt. „Schlussfolgerer“) ein owl:sameAs findet, so führt er alle Aussagen zu den als identisch angesehenen Entitäten zusammen, als würde es sich tatsächlich um eine einzige Entität handeln.

Das heutige Linked Data Netzwerk insgesamt ist sicher keine qualitätsgesicherte Datenbasis für Anwendungen künstlicher Intelligenz. Es ist eher eine Massenbewegung mit dem Schwerpunkt auf Veröffentlichung und Vernetzung, deren Nutzung ein gehöriges Maß an semantischer Fehlertoleranz erfordert. Aber gerade dadurch entsteht eine kritische Masse verfügbarer Daten, ohne die eine realistische Weiterentwicklung von Standards und Anwendungen unmöglich wäre.

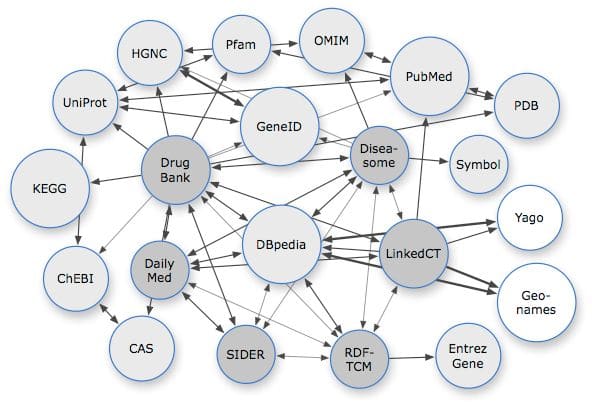

Innerhalb des globalen Netzes, das jeder beliebig erweitern kann, entstehen zunehmend konsistentere Subnetze wie z.B. Linking Open Drug Data [7], die sich mit einzelnen Wissens-Domänen auseinandersetzen und systematisch definierte Use Cases verfolgen.

Abbildung 3 zeigt beispielhaft, dass solche Subnetze sich dennoch auf die allgemeine Folksonomy (DBpedia) beziehen. Wissenschaftlich kontrollierte Referenzsysteme (graue Knoten) stehen nicht isoliert, sondern erlauben einen Zugang aus thematisch übergreifenden oder verwandten Wissensgebieten.

Aktuelles Beispiel: Vernetzte Umweltdaten

Seit Juli 2012 betreibt das Umweltbundesamt ein Pilotprojekt „Vernetzte Umweltdaten“, das zunächst einige beispielhafte Datenbanken in dieser Weise untereinander vernetzt und als Linked Data veröffentlicht.

Schon seit 2003 gibt es mit dem „Semantic Network Service“ [8] eine frei zugängliche Referenz-Terminologie mit einem Thesaurus, dem geografischen Namensgut und einer Umweltchronik. Diese wird derzeit von XML Topic Maps auf Linked Data umgestellt und mit den beteiligten Datenbanken vernetzt.

Beispielweise beobachtet die Umweltprobenbank das Vorkommen von „beta-HCH in Brassen aus der Mulde“. In diesen Datensätzen ist „beta-HCH“ als Link in den Thesaurus abgelegt und man erfährt beim Verfolgen dieses Links, dass es sich um ein Isomer von Hexachlorcyclohexan handelt, ein „monozyklischer chlorierter Kohlenwasserstoff mit der Summenformel C6H6Cl6“. Einen entsprechenden Verweis gibt es auch für „Brassen“, auch „Brasse“ oder „Brachsen“ geschrieben. Für „Mulde“ führt der Link in das geografische Namensgut – ein Nebenfluss der Elbe.

2003 und 2004 wurde hierbei ein sprunghafter Anstieg der Belastung entdeckt, der auf Erdarbeiten und Deichsanierungen nach dem Elbehochwasser 2002 zurückgeführt wird, also zeigt hier ein weiterer Link in die Umweltchronik, wo dieses Hochwasser verzeichnet ist.

Mit der SPARQL Federation ist es einfach, weitere Informationen zu „beta-HCH“, „Brassen“ und/oder „Mulde“ aus anderen beteiligten Datenbanken abzufragen, die vielleicht ebenfalls mit dem Elbehochwasser 2002 zusammenhängen und dies unabhängig von der jeweiligen Schreibweise aller Namen. Da im UBA viele voneinander isolierte Datenbanken mit jeweils unterschiedlich kodierten Entitäten vorliegen, bedeutet dies einen entscheidenden Meilenstein der zuvor mühsamen Datenintegration.

Ein zweiter Anwendungsfall ist das Reporting von den Ländern zum Bund und vom Bund zur Europäischen Umweltagentur. Bisher werden hierbei Datenbankexporte in verschiedenen Formaten und Kodierungen physikalisch übergeben, also repliziert, und müssen vom Empfänger mühselig in gemeinsame Formate konvertiert und zusammengeführt werden. Künftig wird es jeden Datenbestand nur ein einziges Mal geben, nämlich bei der datenpflegenden Behörde. Dort kann er dann über das Verfolgen von Links und mit SPARQL Queries einfach erschlossen werden. Eine länderübergreifende Aggregation wird dann nicht mehr erfordern als eine SPARQL Federated Query, deren Ergebnisse man vielleicht aus Performanzgründen cacht.

Ausblick

Die weitere Entwicklung zur globalen Datenbank wird zwei Schwerpunkte zeigen:

- Nutzerfreundliche, intelligente Anwendungen

- Kommerzialisierung

Da nach den in [6] beschriebenen technischen Patterns jede Webadresse mit Content Negotiation behandelt werden sollte, ist das Browsen und Verfolgen von Links auf menschenfreundliche Art grundsätzlich gegeben. Anders aber das Formulieren von Abfragen und die Darstellung der Ergebnisse. SPARQL ist für IT-Laien ähnlich unbrauchbar wie SQL. Folglich entstehen neue Werkzeuge wie SparQLed [Tools], ein spezieller Editor, der kontextabhängige Auswahllisten anbietet. Allerdings verbirgt er noch nicht die kryptische Syntax.

Die Rückgabe von SPARQL Queries ist frei formatierbar. Es gibt viele Implementierungen, die z.B. thematische Karten über JSON Schnittstellen füttern. Von der Herkunft der Daten aus dem Linked Data Web ist hier nichts mehr zu sehen.

Für engere Schema-Welten entstehen spezialisierte Werkzeuge wie der Data Cubes Viewer [Tools] für statistische Daten.

Es ist anzunehmen, dass die zu erwartende Kommerzialisierung bestehende Lücken schließen wird, wie dies auch im bisher bekannten Internet geschehen ist. Bis heute sind neben akademischen und Regierungs-Institutionen einige namhafte Medienunternehmen vertreten, aber dabei wird es nicht bleiben. Linked Data eignet sich z.B. für verteilte Produktkataloge, die jedermann strukturiert abfragen kann. Bisher ist dafür HTML MicroData etabliert. MicroData annotiert das übliche HTML mit einigen in Standardisierung befindlichen Attributen, die z.B. von Google beachtet und hervorgehoben werden. Suchmaschinen wie Bing, Google, Yahoo! und Yandex haben 2011 schema.org gegründet, um dieses Verfahren weiter zu entwickeln.

Der Linked Data Ansatz geht darüber hinaus, indem hier alle strukturierten Informationen sowohl Menschen- als auch Maschinen-lesbar verfügbar sind, nicht nur einige von Suchmaschinen ausgewählte. Aus diesem Grund wird die Kommerzialisierung des Linked Data Web nicht aufzuhalten sein, ähnlich wie beim heute verbreiteten HTML-Internet. Und schließlich eignet sich diese Technik auch für die interne Anwendung in großen Unternehmen. Der Begriff „offen“ geht dabei zum Teil verloren, aber die Technik entfaltet ihren Wert umso deutlicher.

Referenzen

-

Open Knowledge Foundation (OKFN) Deutschland http://okfn.de/organisation/mission/ ↩

-

Plattform „Offene Daten“ http://www.offenedaten.de/ ↩

-

Barack Obama, Memorandum „Transparency and Open Government“ http://www.whitehouse.gov/the\_press\_office/TransparencyandOpenGovernment ↩

-

Open Government Data Deutschland. Studie zu Open Government in Deutschland im Auftrag des Bundesministerium des Innern. Juli 2012. http://www.bmi.bund.de/SharedDocs/Downloads/DE/Themen/OED_Verwaltung/ModerneVerwaltung/opengovernment.pdf?__blob=publicationFile ↩

-

Gartner, Inc. (2012) Open for Business: Learn to Profit by Open Data. http://www.gartner.com/DisplayDocument?ref=clientFriendlyUrl&id=1947015 ↩

-

Tom Heath and Christian Bizer (2011) Linked Data: Evolving the Web into a Global Data Space (1st edition). Synthesis Lectures on the Semantic Web: Theory and Technology, 1:1, 1–136. Morgan & Claypool. http://linkeddatabook.com/editions/1.0/ ↩

-

Linking Open Drug Data (LODD). http://www.w3.org/wiki/HCLSIG/LODD ↩

-

Semantic Network Service: http://www.semantic-network.de ↩